1. Die reale Situation

Ich erlebte ab 2003 ein Verhalten gegen meine Person, welches mein Vertrauen in die öffentliche Hand nachhaltig erschütterte. Die Justiz NRW agierte wie ein Werkzeug externer Interessen – ohne Rechtsgrundlage, aber mit System.

Dieser durch die Digitalisierung bedingte Vertrauensverlust hat sich inzwischen auf breite Bevölkerungsbereiche übertragen. Auch wenn die meisten es nicht begründen können, so festigt sich doch das Gefühl, dass die Politik nicht mehr gestaltet, sondern oft unreflektiert reagiert.

Der Mannesmann-Prozess (ab 17.02.2003) könnte hier ein Schlüssel sein: Die Digital-Skalierer sahen in mir offenbar eine Gefahr für ihre Pläne. Mein Strafprozess begann am 16.04.2003, basierend auf der haltlosen Anzeige von Frau Wolff (siehe 2001). Die Vorwürfe waren konstruiert: Ich war seit 2000 nicht mehr bei GraTeach verfügungsberechtigt, doch der Staatsanwalt behauptete, ich hätte Unterhaltsgelder treuhänderisch anlegen müssen – ein juristisches Phantom. Da die Unterhaltsgelder zusammen mit Maßnahmekosten mehrfach jährlich ausgezahlt und eben nicht mehr von mir abgerufen wurden, war eine treuhänderische Trennung (durch mich) überhaupt nicht möglich. Die Verurteilung erfolgte ohne Anhörung. Mein erster Verteidiger wurde ausgeschaltet. Nach der Verhandlung kam ein Schöffe zu mir: „Das nächste Mal auf ein Bier,ja?“. Er hatte genau so wenig wie ich verstanden, worum es ging.

Das Verwaltungsgericht stellte 2005 fest, dass die Widerrufsbescheide des Landes rechtswidrig, also Unterhaltsgelder nicht treuhänderisch waren. 2006 scheiterte eine Berufung, weil einem Anwalt vier Stunden vor Verhandlung die Zulassung entzogen wurde. Bis 2009 blockierte das System jede Aufklärung. Man wartete ab, ob ich mich weiter für Demokratie einsetzen würde. 2009 wurde ich unter falschen Voraussetzungen zu einem „Besprechungstermin“ genötigt, der in einer zwischen Verteidigung und Richtern abgesprochenen inszenierten Verhandlung zu meinen Ungunsten endete.

Insgesamt bin ich 11 Jahre von der Justiz dafür verfolgt worden, weil ich mich für den Erhalt der Demokratie eingesetzt habe. Was sagt das über die Fremdbestimmung von NRW aus?

2. Entwicklung ohne Behinderung

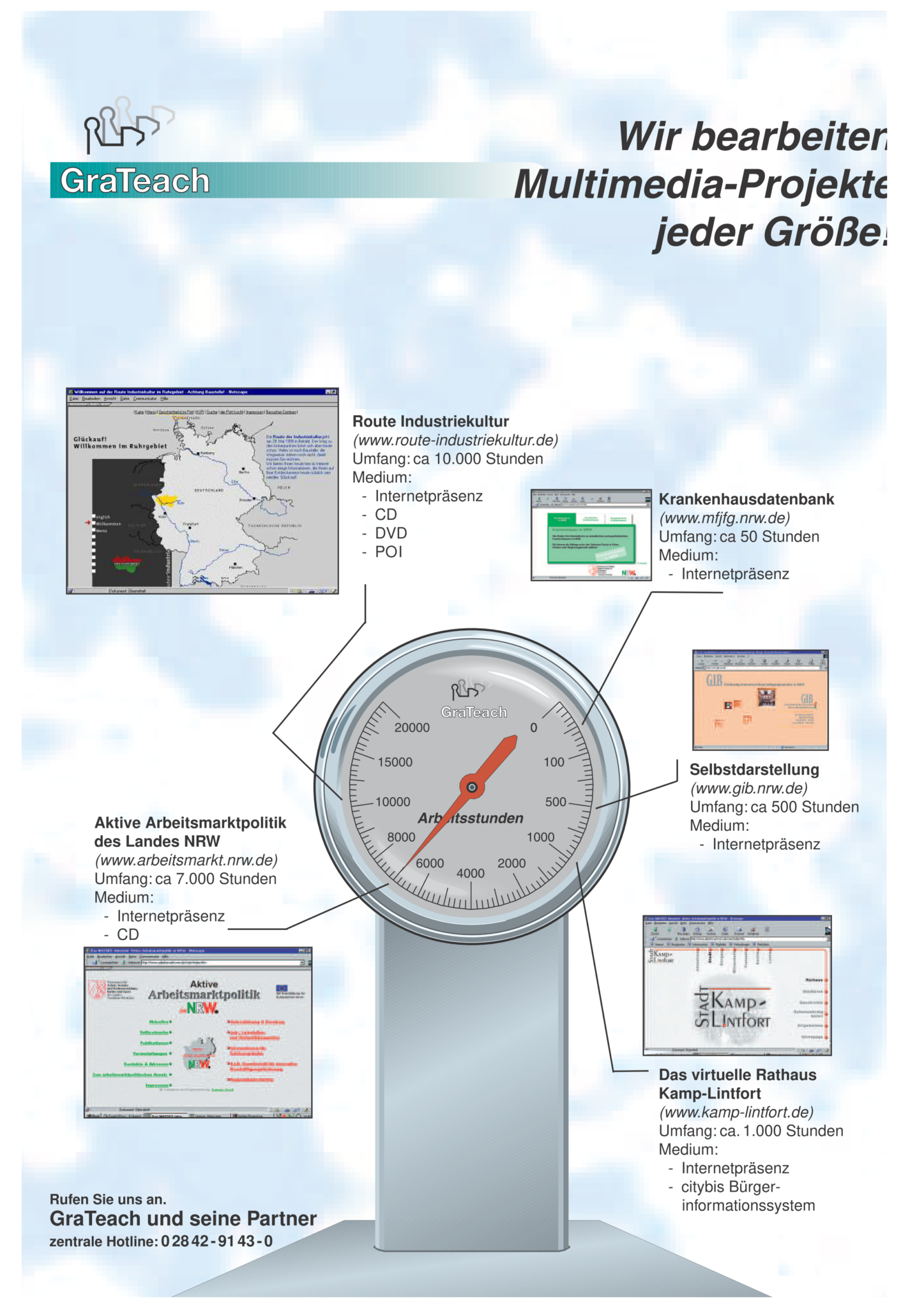

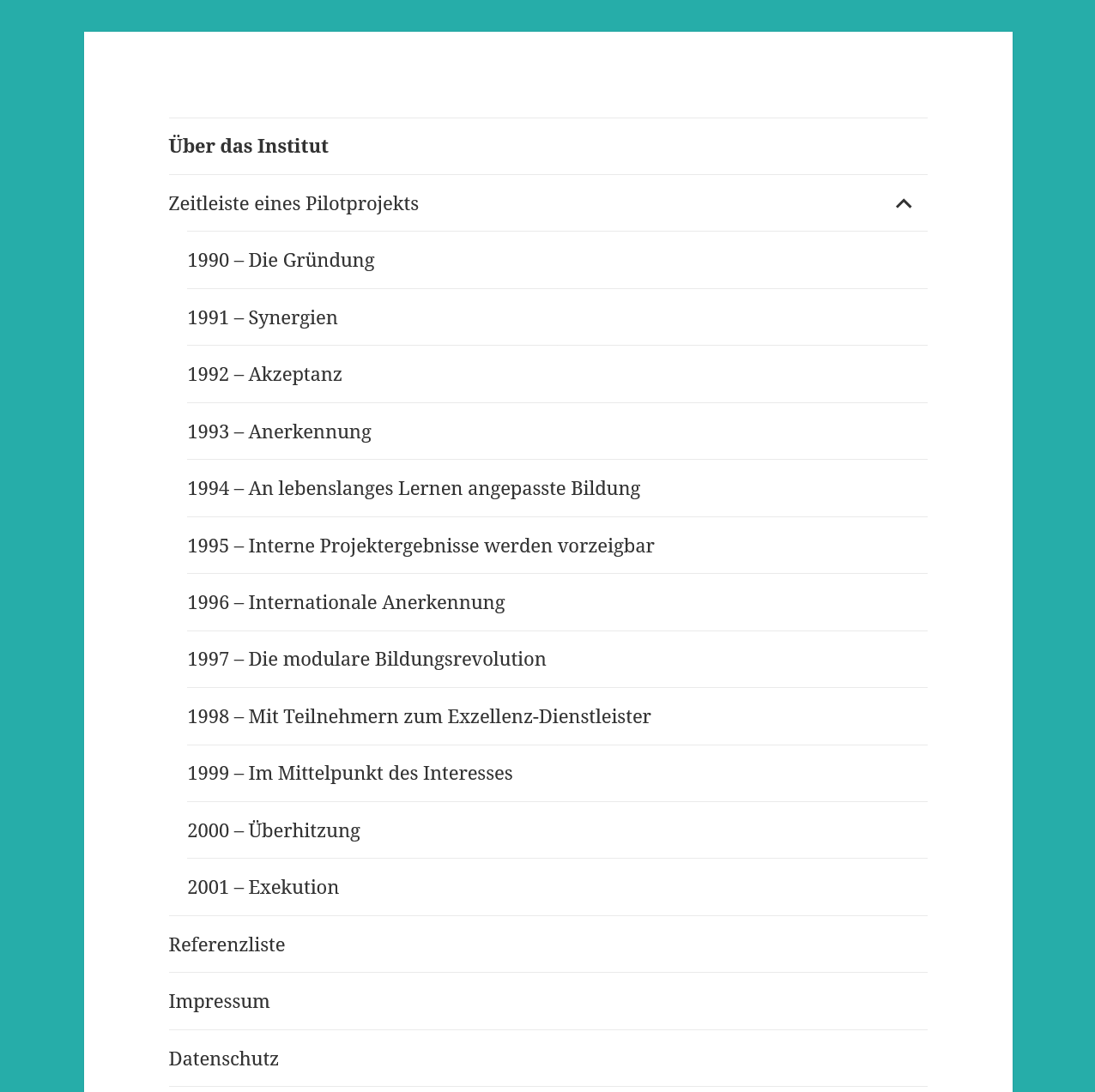

Hätte es diese Angriffe nicht gegeben, wäre GISAD 2003 gegründet worden. Die Institution hätte unabhängige Gutachten zur gesellschaftlichen Strukturrelevanz erstellt – ein Gegenentwurf zur digitalen Autokratie. Stattdessen wurde ich isoliert, meine Arbeit sabotiert. Das Ziel: Verhindern, dass Europa eine eigene digitale Agenda entwickelt.

GraTeach hätte noch bestanden und wäre entweder selbst oder als gespiegeltes Konzept europaweit verbreitet worden. Dadurch hätte GISAD den Rückhalt, um neue Kennzahlen zur gesellschaftlichen Strukturrelevanz zu entwickeln, diese zu evaluieren und neue Projekte zu identifizieren. Dabei geht es nicht um ein neues Bürokratietool, sondern lediglich um eine einfache Möglichkeit, die Übereinstimmung und damit auch die nachhaltige Akzeptanz der eigenen Produkte mit der gesellschaftlichen Entwicklung zu reflektieren.

Die Kennzahlen bilden die Ziele der EU ab.

3. Blick aus der Zukunft (2026): Der Kill-Switch und seine Folgen

In den letzten Jahren habe ich viele Förderangebote der EU und auch von NRW bekommen. Doch NRW kann mich jederzeit wieder in einem leider für digitale Freiheitskämpfer fiktiven Rechtstaat ausschalten, ohne dass ich mich dagegen wehren könnte. Sowohl ein fehlender Anreiz wie auch das nicht kalkulierbare unternehmerische Risiko hindern mich daran, noch einmal mit Fremdmitteln zu arbeiten. Für die Gründung von GISAD wäre das auch nicht nötig. Es würde reichen, wenn der RVR seine offene Rechnung bezahlt.

Artikel 20 GG ist klar: „Alle Staatsgewalt geht vom Volke aus.“ Doch die Realität sieht anders aus. 2023 widersprach mir keine Ampel-Politiker:in, dass das Widerstandsrecht nach Art. 20 Abs. 4 erfüllt ist. Das Bundesverfassungsgericht ignoriert meine Beschwerden. Die Bundesrechtsanwaltskammer schweigt. Die Justiz ist kein Schutzraum mehr, sondern Teil des Problems. Der RVR schuldet GraTeach Millionen – Geld, das GISAD finanzieren könnte. 30% der Forderung stelle ich als Prämie für rechtliche Unterstützung bereit. Ein Prozesskosten-Finanzierer hat Interesse signalisiert. Eine Klageschrift ist vorhanden. Doch selbst in den Niederlanden findet sich keine Kanzlei, die den Fall übernimmt.

Die Frage ist: Will man GISAD überhaupt? Oder fürchtet man eine Kennzahl, die den Verlust vordigitaler Errungenschaften misst, weil alle Demokratie erhaltenden Projekte boykottiert werden – und eine Kennzahl beweisen würde, dass die Verfassungsordnung bereits ausgehebelt ist? Wer sich nur auf Gesetze verlässt, die immer der Realität hinterherhinken und nicht proaktiv gestaltet, handelt grob fahrlässig, denn Gesetze sind dazu da, um eine gestaltete Realität zu regeln.

Die Dienste, die mich schützen sollten, sind selbst im Daten-Wettrüsten gefangen. Sie können nur mithalten, wenn sie mit den Gatekeepern paktieren.

Mein neues getmysense-Patent aus 2026 zeigt einen anderen Weg: KI, die menschliches Handeln einbezieht. Doch solange Gründer nur auf US-Exits starren, bleibt Europa abhängig. Doch wer kann es umsetzen? Nur eine große Gruppe von Gründern, die stark genug sind, dass man sie nicht ausschalten kann.

Konsequenz: Ohne Aufarbeitung der Vergangenheit gibt es keine demokratische Zukunft. Der Rechtsweg ist blockiert. Wenn NRW sich weigert, die Schadensersatzforderung gegen den RVR anzuerkennen, bleibt nur der Widerstand – oder der Beweis, dass die Verfassung bereits suspendiert ist. Wer das Eintreten des 20 (4) GG bestreitet, möge GraTeach für die nicht verjährten Ansprüche einen Anwalt stellen!

Man meint die zunehmend gefährliche Weltlage durch Aufrüstung und Kriege lösen zu können. Doch wenn die Gesellschaft bereits digital versklavt ist, hilft das nicht mehr dem Erhalt der Demokratie.

Neue Möglichkeit zum Erhalt der digitalen Souveränität

Sollte Deutschland nicht mehr den Willen zum digitalen Erhalt der Demokratie aufbringen, dann bleiben nur die anderen EU-Staaten, um im EU-D-S den Erhalt der EU-Charta sicherzustellen.

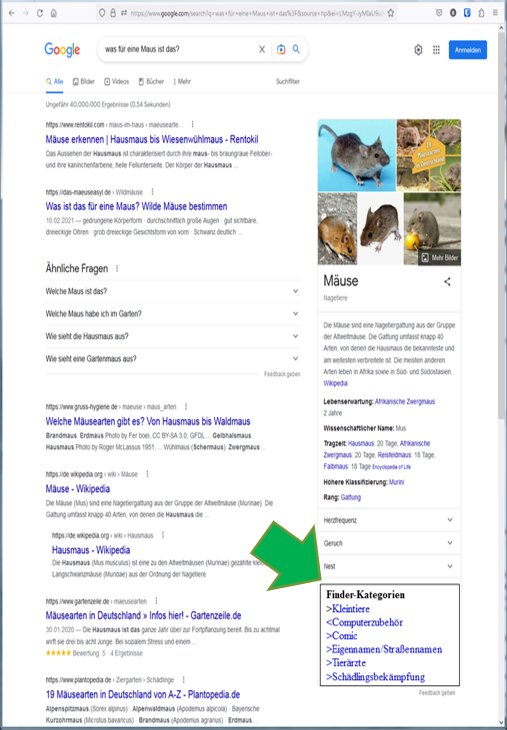

Unter der Priorität vom 12.02.2026 habe ich mit der Nummer 10 2026 000 788.7 ein auf die heutige Situation angepasstes Patent zur Finder-Technologie angemeldet. Mit der im Patent zugrunde liegenden Annahme, in möglichst viele KI-Schritte Menschen einzubinden, können wir uns an die Spitze der demokratischen, mit KI generierten Wertschöpfung setzen. KI-Entwickler sind aufgefordert, sich in dieses Konzept im EU-D-S einzubringen. Ein Jugendverbot für das darauf aufbauende Social-Media-Konzept GetMySense wäre unsinnig. Jugendliche bauen hier ohne Fakes konsequent ihr eigenes Wissen und Know-how auf und finden bei Gleichgesinnten weltweit Beachtung. Möglichst früh sind sie über dieses Konzept in die soziale gesellschaftliche Kontrolle eingebunden. Staatliches Handeln kann auf ein Minimum beschränkt bleiben.

4. GAP: Kill-Switch schaltet europäische Wettbewerber aus

2003 war das Jahr, in dem Europa die Kontrolle verlor. Die Übernahme von Mannesmann (2000: 133 Mrd. Euro) markierte den Start der digitalen Kolonisierung. Ab 2003 untererfassten US-Konzerne systematisch ihre Umsätze in Europa. Google und Amazon buchten über Steueroasen – geschätzte 5–10 Mrd. Euro fehlten in den Statistiken. Das GAP 2004 (fehlende europäische Alternativen) betrug konservativ 10–15 Mrd. Euro. Hätte es EU-D-S gegeben, wären diese Mittel in europäische Infrastruktur geflossen. Stattdessen finanzierten sie die Expansion der Gatekeeper.

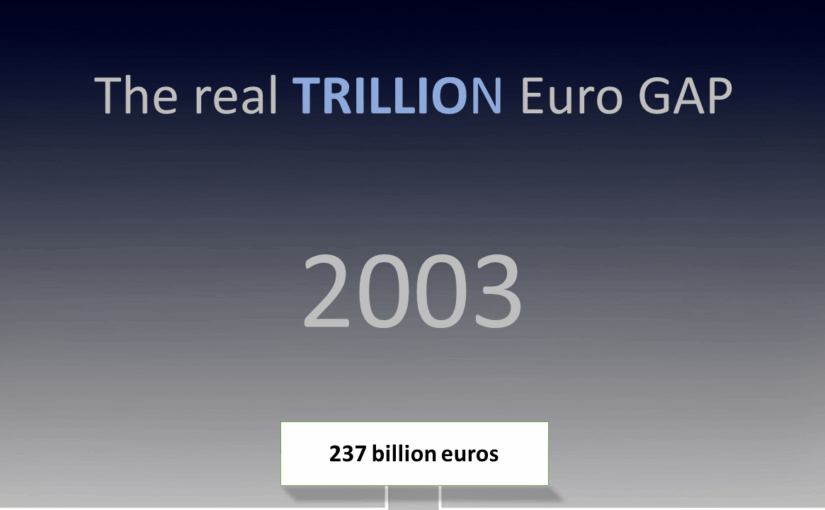

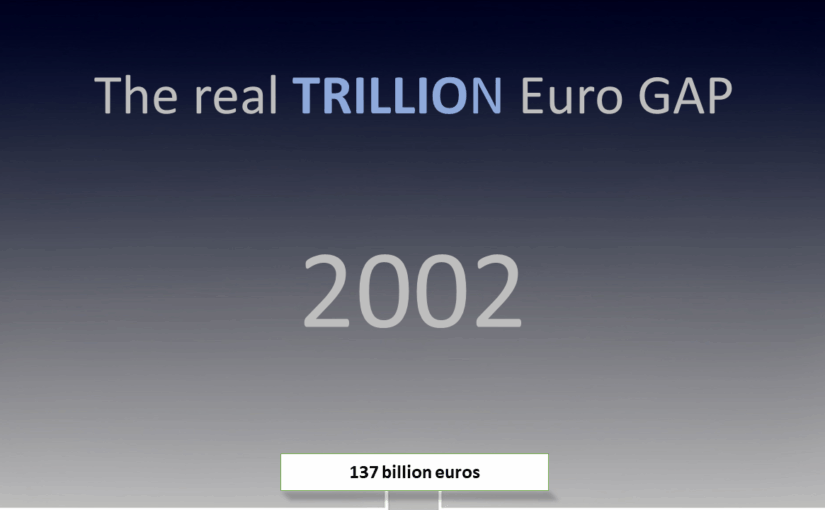

Übertrag des GAP aus den Vorjahren:

- Mannesmann-Übernahme (2000): 133 Mrd. Euro

- Durch blockiertes GraTeach-Teilhabekonzept entstehen:

- Arbeitslosigkeitskosten (2001): 2 Mrd. Euro

- Arbeitslosigkeitskosten (2002): 2 Mrd. Euro

- Arbeitslosigkeitskosten (2003): 2 Mrd. Euro

- Vertrauensverlust in die Wirtschaft und Digitalisierung (1 % vom BIP 2003): 98 Mrd. Euro

Summe 2003 = 237 Mrd. Euro

Vorausschau auf 2004

Ab 2004 werden 30 Prozent des Umsatzes, 2003 wären das 5 Mrd. Euro der Onlineplattformen, als Kill-Switch für europäische Digitalplayer angesetzt.

Hintergrund: Wie Abhängigkeit die digitale Souveränität erstickt

Ich erlebe täglich, wie Lock-in-Effekte wirken – nicht als technisches Phänomen, sondern als politisches Instrument. Hier ist der Mechanismus:

- Die Psychologie der Gewöhnung: Menschen und Organisationen passen sich an Software an wie an eine zweite Haut. Je länger die Nutzung, desto tiefer die Abhängigkeit. Das ist kein Zufall, sondern Design: Plattformen wie Google oder Microsoft schaffen Ökosysteme, in denen der Ausstieg schmerzhaft wird. Daten, Workflows, sogar soziale Netzwerke sind darauf ausgelegt, Nutzer zu binden. Der Wechsel ist nicht nur technisch aufwendig, sondern psychologisch belastend – wie ein Umzug in ein fremdes Land, nur ohne die Freiheit, die Sprache zu wählen.

- Die Illusion der Alternativlosigkeit: Je dominanter eine Plattform wird, desto mehr entwickelt sie sich für ihre Nutzer – aber nicht mit ihnen. Die scheinbare Ausgereiftheit ist ein Teufelskreis: Weil alle sie nutzen, wird sie besser; weil sie besser ist, nutzen alle sie. Wer dann doch wechselt, zahlt einen Preis: höhere Kosten, verlorene Daten, verlorene Zeit. Das ist kein fairer Wettbewerb, sondern eine Falle.

- Die politische Dimension: Lock-in ist kein Marktversagen, sondern Machtausübung. Wer die Infrastruktur kontrolliert, kontrolliert die Regeln. Europa hat jahrzehntelang zugesehen, wie US-Konzerne diese Infrastruktur aufgebaut haben – und damit auch die Abhängigkeit. GISAD hätte hier gegensteuern können: als Instanz, die misst, wie viel Souveränität wir verlieren, und als Katalysator für echte Alternativen.

- Der Kill-Switch als System: Mein Fall zeigt, wie gezielt Innovationen behindert werden, die diesen Lock-in durchbrechen könnten. Getmysense oder EU-D-S sind nicht nur technische Projekte, sondern politische Akte: Sie würden die Macht der Gatekeeper infrage stellen. Dass sie blockiert werden, ist kein Zufall – es ist Teil des Systems.